网络安全没有灵丹妙药。供应商希望创建防黑客的防御措施,但攻击者总能找到偷偷摸摸的方法。

多因素身份验证 (MFA),也称为 2FA,就是一个很好的例子。在某些形式中,它在防止攻击方面表现出色,但并非万无一失。只需问问去年由于 Coinbase 的 MFA 系统存在缺陷而导致账户遭到黑客攻击而丢失加密货币的 6,000 名客户。

这就是为什么公司不能依靠单一形式的防御来保护自己。相反,他们需要分层措施。

网络安全公司 Darktrace 使用人工智能来寻找整个组织的攻击。它警告公司将这些防御层层加厚,让他们有足够的机会发现和减轻攻击。如果一个人不停止攻击,另一个人会。

从网络钓鱼到 MFA 绕过

与 Coinbase 事件一样,许多 MFA 绕过攻击始于网络钓鱼攻击。攻击者需要基本的身份验证因素 - 用户的电子邮件地址和密码 - 甚至试图劫持帐户。

通过虚假电子邮件和网站对这些细节进行网络钓鱼是一种日益增长的攻击媒介。根据 Verizon 的数据泄露调查报告 (DBIR) ,它是去年 36% 的泄露事件的组成部分,高于前一年的 25%。

组织使用 MFA 来保护用户免受这些攻击。有了 MFA,窃取密码是不够的。它需要另一个因素——你拥有的东西(如智能手机或硬件令牌)或你的东西(生物识别技术)来确认你的身份,然后才能让你进入。理论上,攻击者必须在劫持你的帐户之前获得该资产。

在实践中,攻击者已经找到了许多绕过 MFA 的方法。其中之一是在网络钓鱼过程中收集 MFA 详细信息。如果一个网络钓鱼网站足以欺骗受害者输入他们的详细信息,那么他们可能也会批准它发送的任何 MFA 消息。

这是中间操纵者 (MITM) 攻击。恶意站点冒充合法站点并引诱受害者提交其凭据,然后它使用这些凭据访问真实站点。合法站点会发送一个 MFA 请求作为回报,网络钓鱼站点会将其传递给受害者。当受害者使用他们的第二个因素批准它时,攻击者然后使用 Evilgenix 之类的工具窃取用户的会话 cookie,然后将 2FA 代码传递到合法站点。

Evilgenix 只是用于自动化网络钓鱼和 MFA 绕过攻击的一种工具。Mariana 是一个透明的反向代理,可捕获凭据和会话 cookie。然后,它将这些信息传递给 Necroses,后者使用它们模拟受害者,使用基于容器的 Chrome 浏览器,使被盗会话保持活动状态。

对 SMS MFA 的攻击

虽然 MITM 攻击将自己置于用户面前,但另一种方法是完全取代受害者。这就是 SIM 卡交换的工作原理。它依赖于用于向智能手机发送密钥的带外 SMS 通道中的缺陷。

SIM 就像您用来访问蜂窝网络的数字密钥。SIM 交换器会将密钥从受害者的 SIM 切换到他们自己的。此时,他们的手机代替了受害者在网络上的手机、电话号码等等。

SIM交换犯罪分子通过向运营商拨打社会工程电话或通过为电信公司工作的想要快速获利的内部人员来进行这种改变。

越来越多的有组织的团体会派青少年突袭运营商的商店,抢走经理的平板电脑,然后将其交给同伙,在运营商冻结经理的访问权限之前,他们将使用它来切换尽可能多的 SIM 卡。他们将在实时论坛中接受这些 SIM 卡交换的订单。暗网日记对该过程进行了出色的细分。

短信的攻击面很难管理。过去,研究人员还找到了利用 SS7 蜂窝路由协议中的缺陷来选择基于 SMS 的 MFA 的方法。然而,即使NIST在五年前就警告不要使用 SMS 进行身份验证,人们仍在继续这样做。

FBI 在 2019 年 9 月通过私营行业通知警告了这个问题。它警告说,它已经在野外看到了 MFA 规避。它报告了几起 SIM 卡交换案例,其中包括 2016 年的一起美国银行客户受到打击的案例。

肇事者窃取了受害者的电话号码,然后用它们打电话给银行并要求电汇。银行将该号码识别为客户的号码,跳过了安全问题并通过短信发送了一次性密码。攻击者还更改了客户的 PIN 和密码,并将他们的信用卡号附加到移动支付应用程序中。

脆弱的基础设施

该私人通知还强调了 MFA 的另一个常见问题:网站漏洞。它描述了 2019 年的一起事件,攻击者使用被盗的客户凭据登录美国银行。当网站要求提供 PIN 码时,犯罪者更改了网站 URL 参数,以将他们的计算机标识为帐户中可识别的计算机。该网站在没有强迫他们输入 PIN 的情况下挥手让他们通过。

其他漏洞存在于用于对用户进行身份验证的协议和工具中。2020 年,研究人员发现黑客使用 WS-Trust(一种用于管理安全令牌的 OASIS 标准协议)滥用 Microsoft 365 帐户。攻击者可以使用此协议通过操纵请求标头来欺骗他们的 IP 地址来完全绕过 MFA。他们还可以更改用户代理标头,以使身份提供者相信他们正在使用 Microsoft 的现代身份验证,这是一种使用 MFA 和数字令牌进行身份验证的协议。Microsoft 于 2020 年 2 月取消了对 WS-Trust 的支持。

有时,其他软件缺陷会使 MFA 解决方案的组件易受攻击。我们在 12 月与企业单点登录和 ID 管理公司 Okta 看到了这一点,该公司警告说 Log4j 漏洞影响了其 RADIUS 服务器代理和本地 MFA 代理。

依赖管理员错误和恶意用户

有时,根本不需要代码漏洞;简单的错误配置就可以解决问题。这就是 2021 年发生的事情,当时国家资助的俄罗斯黑客获得了访问受 MFA 保护的非政府组织的权限。

他们通过暴力破解受害者的密码进入,结果证明这是可以预测的,使其容易受到字典攻击。该账号本应受到非政府组织MFA系统的保护,但该用户已很久没有访问该账号。

非政府组织取消了未使用的帐户的注册,即使它仍然处于活动状态。MFA 系统的默认配置允许攻击者为自己的设备注册 MFA 服务,从而使他们能够访问 NGO 的网络。整个事件意义重大,足以引发另一次政府警告。

其他技术包括简单地向具有受信任访问权限的人付款,以帮助攻击者使用他们的 MFA 帐户登录。根据微软的分析,这是 Lapsu$ 小组用来访问受 MFA 保护的系统的一种技术。

Lapsu$ 还使用被盗密码向个别目标发送垃圾邮件,并不断请求 MFA 批准。一些 MFA 服务只是简单地 ping 个人的设备,要求他们批准登录。经常这样做,分心的用户可能会批准请求,而不是怀疑攻击,从而使烦人的消息消失。

更深层次的防御

当有人突破像 MFA 这样的可信防线时会发生什么?希望其他保护层也能发挥作用。Darktrace 表示,早期检测很重要,这样安全团队才能快速做出反应。

选择或绕过 MFA 的攻击者尽最大努力在雷达下飞行,看起来很正常,这样管理员就不会发现任何危险信号。

该公司建议,这就是基于规则的系统崩溃的地方。如果您正在寻找特定的、已知的入侵迹象,那么成功使用 MFA 并保持低调的攻击者将很难被发现。

Darktrace 并没有寻找具体的妥协指标,而是假设冒名顶替者最终会做一些不寻常的事情。他们必须这样做,因为他们的目标是使用该帐户进行非法活动。

该公司采用不同的方法来发现与正常行为的偏差。它不是寻找已知的恶意迹象,而是采用广阔的视野,调查数千个日常数据点。

它的技术使用机器学习来创建这种遥测的统计模型。然后,它将新活动与该模型进行比较,以发现模式偏差。

从这个意义上说,人工智能不仅仅是一层额外的保护,而是一个复杂的传感器组合,可以监视跨多个域的可疑活动。

这有助于将Darktrace 的一位客户从去年绕过其 MFA 的网络钓鱼攻击中解救出来。攻击者以金融客户的 Microsoft 365 帐户为目标,使用钓鱼凭据,但不知何故更改了受害者的注册电话号码。这使攻击者能够接收 Microsoft 的 MFA 文本身份验证消息。

在获得对该帐户的访问权限后,攻击者更改了其电子邮件规则并共享了多个收件箱。他们还从用户的电子邮件历史记录中访问了多封邮件,并删除了几封邮件以掩盖他们的踪迹。

Darktrace 提供了一款名为 Cyber AI Analyst 的产品,可以发现异常行为并自动分析威胁。该产品还扫描 Microsoft 365 等 SaaS 帐户,构建事件的自然语言摘要并将其发送给人类分析师。这使客户能够采取行动。

随着攻击者变得越来越狡猾,防御者将需要更多的保护层来发现和消除入侵。MFA 会有所帮助,但它不是 100% 防黑客的 -无论如何,只有五分之一的企业使用它,我们拥有的集成保护越多,我们就会越好

南约克郡的部分地区将在为期两年的试验中通过主水管铺设光纤宽带,以评估该技术连接更多家庭的可行性。

根据政府批准的技术试验,此举将使光纤电缆穿过巴恩斯利和佩尼斯顿之间 17 公里的水管。该项目似乎是去年宣布的 400 万英镑基金的一部分,该基金旨在尝试在不挖掘道路的情况下连接难以到达的房屋的方法。

试验的另一部分将测试安装在水管内的纤维是否可以用来帮助水公司检测泄漏,从而减少水的浪费。

根据数字、文化、媒体和体育部的说法,新项目有可能将多达 8,500 个家庭和企业连接到更快的宽带,但似乎由宽带运营商来实际接入光纤管道并提供与用户家中最后几米的连接。

事实上,DCMS 的一位发言人告诉我们,试点的目的之一是检查部署的各个方面,以确保能够提供可行的商业服务,因此在这两个时期似乎没有任何家庭实际上会被连接-一年试用,但只有在证明成功后才能试用。

DCMS 还表示,从今天开始的项目的第一阶段将只关注该解决方案的法律和安全方面,以确保在任何技术实际应用之前将水和电信服务结合在一条管道中是安全、可靠和商业上可行的安装。

发言人告诉我们,这个调查阶段现在开始,预计在 2023 年 5 月 31 日之前完成,大约 12 个月后将进行现场审判。该项目的最后一年将专注于制定更广泛部署的路线图。

据 DCMS 称,如果成功,该项目可以在该国其他地区复制,并可以推动政府的千兆项目。这是去年宣布的,旨在连接数百万目前宽带服务不佳的农村家庭和企业,通常是因为电信公司认为在其所在地铺设光纤是不经济的。

约克郡和林肯郡显然有超过 300,000 户农村家庭和企业正在等待升级,其中 56,800 户位于将进行试验的南约克郡。

“我们致力于让全国的家庭和企业连接到更好的宽带,这个尖端项目是政府正在采取的大胆措施的一个令人兴奋的例子,旨在通过最好的数字连接来升级社区,”Digital 说基础设施部长朱莉娅洛佩兹在一份罐头声明中。

该项目由 Yorkshire Water 与可持续设计和工程咨询公司 Arcadis 以及斯特拉斯克莱德大学共同领导。涉及管道中光纤传感器的测试是为了看看自来水公司是否可以使用该技术来提高他们识别泄漏和修复泄漏的速度和准确性,最好是在它给消费者造成问题之前。

Arcadis 还参与了另一个当前混合水和数据的项目——将数据中心与韩国的污水处理厂共存以节省能源和水。

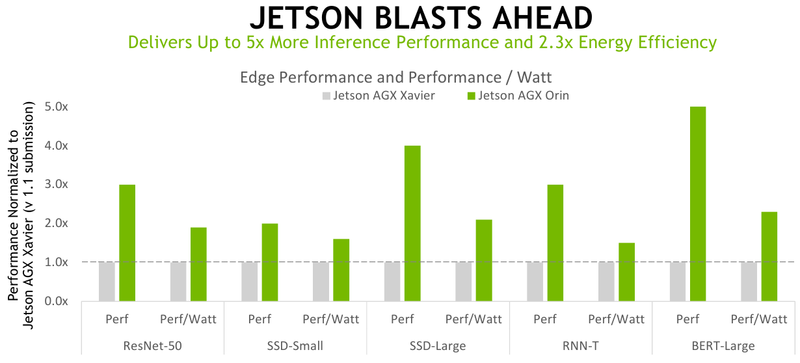

Jetson AGX Orin平台于 3 月底推出。根据 NVIDIA 的说法,这是使用现代 AI 解决方案的机器人和自动驾驶汽车的最佳紧凑、经济高效且性能非常好的解决方案。该公司有充分的理由这样做。

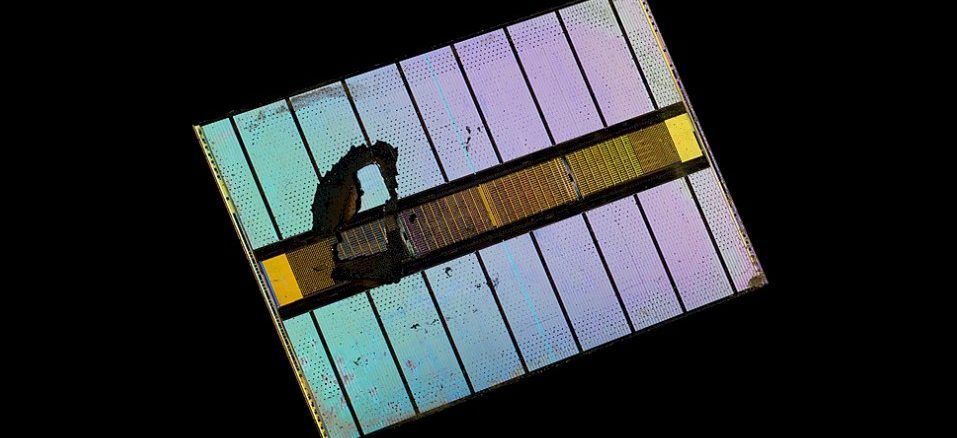

该平台的核心是一个 7nm 芯片(170 亿个晶体管),其中包括 12 个 Arm Cortex-A78AE 内核,专为需要更高可靠性的应用而设计。GPU部分由2048个安培核心和64个张量核心代表。在完整版中,这种芯片在 INT8 计算上开发了 275 TOPS,CPU 频率为 2.2 GHz,GPU 频率为 1.3 GHz,但 NVIDIA 提供了几种基于新架构的解决方案。

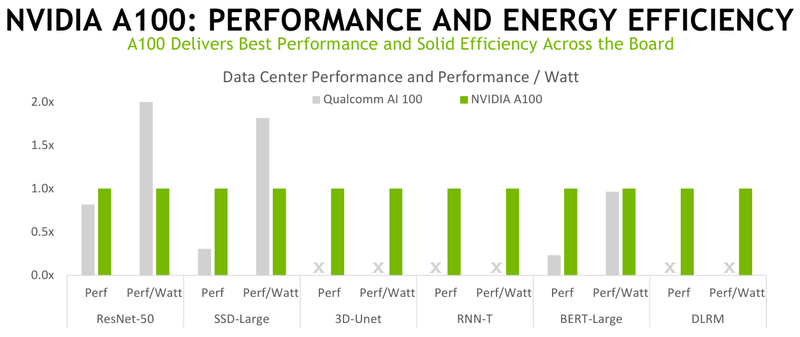

旧版本的速度比Jetson AGX Xavier快 5 倍,能效提高 2 倍——该公司将 AGX Orin 的测试结果带到 MLPerf Inference V2.0 中,新平台轻松应对其前身,也几乎没有机会适用于 Qualcomm 捆绑包 Snapdragon 865 和Cloud AI 100 (DM.2)。然而,在其他一些测试中,与NVIDIA A100相比,较旧的服务器版本的加速器仍然更节能。

此外,NVIDIA还公布了A30加速器的测试结果。该公司特别强调了几点。因此,A100 在 Arm 和 x86-64 平台上的性能几乎相同——将软件移植到 Arm 的三年努力并没有白费。更重要的是,仅优化软件一项在过去一年中就增长了高达 50%。同时,英伟达宣布,现在Triton推理平台只能在 CPU 上运行,不需要强制存在 GPU。

此外,NVIDIA 与 Microsoft 一起表明,A100 在Azure实例中的性能与使用裸机硬件可以获得的性能略有不同。最后,该公司展示了多实例 GPU (MIG) 的性能——当使用所有七个实例时,每个实例的性能约为仅使用一个实例时可用性能的 98%。

不幸的是,MLPerf 套件本身仍然主要专注于 NVIDIA 硬件解决方案——在新系列的测试中,其他主要参与者的结果很少,尽管总共进行了 3900 多次测量,其中 2200 次还包括功耗数据。同样的高通没有在所有学科都有表现,谷歌实际上拒绝参加这一轮。

加拿大政府本周推出了一项法律法案,该法案将迫使谷歌和 Facebook 等公司向加拿大新闻出版商支付费用,让他们在网上使用他们的文章。

《在线新闻法》旨在解决加拿大遗产部长 Pablo Rodriguez 所说的该国媒体部门的危机,该危机已导致 2008 年至 2015 年间 451 家媒体消失。“我们希望确保新闻媒体和记者获得公平的补偿他们的工作。我们希望确保本地独立新闻在我们国家蓬勃发展,”罗德里格斯在一份新闻声明中说。

具体来说,拟议的法律旨在确保记者和出版商从大型科技银行聚合、分发、分享或总结故事的收入中获得公平的分成;具体安排尚未敲定。

相关科技公司,特别是谷歌和 Facebook 对该法案的反应包括希望与加拿大政府合作,以寻求令人满意的解决方案。两人都表示他们仍在审查立法。

加拿大还在该法案宣布前听取了新闻机构和记者的反馈,官员们表示, “绝大多数意见都强调了采取行动应对新闻业收入下降的重要性。” 受访者还表示,他们对新闻发行商和新闻机构之间的权力不平衡感到担忧,尽管对于政府应该如何采取行动没有达成共识。

Rodriguez 表示,加拿大法案的灵感来自澳大利亚的《新闻媒体谈判守则》,该守则的目标是向新闻聚合商收取使用澳大利亚内容的费用。

与澳大利亚的法案一样,加拿大的法案赋予新闻媒体与在线分销商集体讨价还价的权力,以实现公平的收入分享模式。它包括在无法达成协议时制定仲裁监管框架的规定,并惩罚违反该法案的公司,加拿大广播电视电信委员会 (CRTC) 有权这样做。

并非所有新闻聚合平台都属于该法案。它特别指出,具有预先存在协议的平台(根据新法案仍被认为是公平的)和那些不存在议价不平衡的平台将被豁免,如果满足额外的标准,新闻中介可以申请豁免。

最终,目标是“监管数字新闻中介,以提高加拿大数字新闻市场的公平性并促进其可持续性,包括独立本地新闻业务的可持续性,”该法案称。

与科技行业对澳大利亚法律的反应相反,它对加拿大的反应是彻头彻尾的胆怯。当 Facebook 听说澳大利亚的计划时,它阻止了用户在其社交网络上分享任何澳大利亚新闻文章的能力,然后才同意取消禁止内容并与政府签订和平协议。

与此同时,谷歌表示,如果被迫为新闻付费,它将把其搜索引擎撤出澳大利亚,不过此后已投资近 10 亿美元来扩大员工人数并发展其在该国的云业务。

澳大利亚的法案通过并于 2021 年 3 月 2 日生效,Facebook 和谷歌都没有离开 Down Under。现在,随着加拿大计划制定相同的措施,双方似乎都不想抗拒为新闻支付更多费用的前景。

《在线新闻法》仅在加拿大下议院进行了初审,这仍然让大型科技公司及其盟友有时间决定是否以及如何对其提出异议。

在某种程度上,计算系统中唯一真正重要的是它的内存发生了什么变化,在某种程度上,这就是让计算机像我们这样的原因。世界上所有的计算能力,或者数据的操作或转换类型,都没有创建新数据那么重要,然后将新数据存储在内存中,这样我们就可以以某种方式高速使用它。

系统及其内存的问题在于,您无法拥有一个拥有一切的内存子系统。

您可以将 3D XPoint 变成一种主内存,正如英特尔在其 Optane PMem DIMM 外形中所展示的那样;PMEM 中的这种持久性很有用,但您最终会得到一个比闪存更昂贵且比普通 DRAM 慢的内存,因此它不能真正完全替代任何一个,但它可以用作内存层次结构中的另一层——并且在某些系统和存储。

使用普通的 DRAM,你可以为应用程序和数据构建一个大的内存空间,但它可能会变得昂贵并且带宽不是很大。内存速度的提高和 CPU 上控制器数量的增加有所帮助,但延迟仍然相对较高(至少与 HBM 堆叠内存相比),并且带宽远不及 HBM 高。该行业确实知道如何大批量生产 HBM,因此产量较低且单位成本较高。

DDR DIMM 无处不在——现在已经有五代了——它们的大规模生产意味着即使带宽受到挑战,它也是低成本的。DDR SDRAM 内存由 JEDEC 于 1998 年指定,并于 2000 年广泛商业化,首次推出时的低频率为 100 MHz,最高频率为 200 MHz,每通道的带宽在 1.6 GB/秒和 3.1 GB/秒之间。通过 DDR 代,内存时钟速率、I/O 总线时钟速率和内存模块的数据速率都在增加,容量和带宽也随之增加。DDR4 仍然普遍用于服务器,高端模块的内存运行频率为 400 MHz,I/O 总线速率为 1.6 GHz,数据速率为 3.2 GT/秒,每个模块的带宽为 25.6 GB/秒。DDR5 将带宽翻倍至 51.2 GB/秒,并将每个记忆棒的最大容量翻倍至 512 GB。

我们的猜测是,对于许多设备来说,这种容量很大,但带宽根本不够用。因此,在可预见的未来,我们最终会在节点内部实现拆分内存层次结构并靠近计算引擎。或者,更准确地说,客户必须在具有 DDR5 内存和 HBM3 内存的设备之间进行选择,他们可能会在系统内和集群中的节点之间混合使用它们,其中一些可能具有 Optane 或其他类型的 ReRAM 或 PCM 持久内存在适当情况下。

跨主要内存类型和速度的编程对于混合内存系统来说仍然是一个问题,直到有人创建一个内存处理单元和一个内存管理程序,可以为计算引擎提供单级内存空间来共享——Memverge,VMware 你在听吗?

或者,公司将使用一种类型的内存来缓存另一种。快而瘦的内存可以缓存肥而慢的内存,反之亦然。因此,在当今的许多混合 CPU-GPU 系统中,GPU 内存是完成大部分处理的地方,CPU 中的 DDR 内存和 GPU 中的 HBM 内存之间的一致性主要用于让 DDR 内存发挥巨大作用GPU 的 L4 缓存——是的,CPU 已被降级为数据管家。相反,对于支持 Optane DIMM 的 Xeon SP 系统,在其中一种模式(也是最容易编程的模式)中,3D XPoint 内存被视为慢速主内存,机器中的 DDR4 或 DDR5 DIMM 是一种超级Optane 内存的快速缓存。

正如我们去年 7 月在预览 HBM3 内存在今年可用时对系统可能意味着什么时指出的那样,我们认为 HBM 内存 - 永远不要将您正在创建的事物的名词放在缩写中,因为我们不能说高带宽内存内存,HBRAM出了什么问题?– 将用于各种系统,最终将变得更加普遍,因此更便宜。毕竟,我们并不都仍然使用核心内存,而且很多工作负载都受到内存带宽的限制,而不是计算。这就是为什么我们相信会有更窄的 512 位总线和无插入器的 HBM 版本以及具有 1,024 位总线和插入器的版本。

使用 HBM 内存(以及英特尔和美光曾经创建并用于其至强融核加速器的现已失效的混合内存立方体堆叠内存),您可以堆叠 DRAM 并将其链接到非常接近计算引擎的非常宽的总线并将带宽提高许多因素,甚至比直接连接到 CPU 的 DRAM 上看到的带宽高一个数量级。但是这种快速的 HBM 内存很薄,而且价格也相当昂贵。它本质上更昂贵,但内存子系统的价格/性能可能会更好。

与 DDR 主存相比,HBM 成本多少我们并不清楚,但 Rambus IP 内核产品营销高级总监 Frank Ferro 知道与 GDDR 内存相比它的成本是多少。

“GDDR5 与 HBM2 的加法器大约是 4 倍,”Ferro 告诉The Next Platform。“原因不仅在于 DRAM 芯片,还在于中介层和 2.5D 制造的成本。但是 HBM 的好消息是您可以获得最高的带宽,您可以获得非常好的功率和性能,并且您可以获得非常小的占地面积。你必须为这一切付出代价。但 HPC 和超大规模社区并没有特别受成本限制。他们当然想要更低的功率,但对他们来说,一切都与带宽有关

Nvidia 知道 HBM3 内存的好处,并且是第一个在上个月宣布的“Hopper”H100 GPU 加速器中将其推向市场的公司。在 JEDEC 在 1 月份推出最终 HBM3 规范之后,这非常热门。

HBM3 规范的出台速度比 SK Hynix 去年 7 月在其早期工作中所暗示的要快,当时它表示预计每个堆栈至少有 5.2 Gb/秒的信号传输和至少 665 GB/秒的带宽。

HBM3 规范要求每针信号速率从三星实现 HBM2E 时使用的 3.2 Gb/秒翻倍至 6.4 Gb/秒,HBM2E 是 HBM2 的扩展形式,将技术推向了官方 JEDEC 规范之外,该规范设置了信号最初的速率为 2 Gb/秒。(有一个早期的 HBM2E 变体使用 2.5 Gb/秒信号,而 SK 海力士使用 3.6 Gb/秒信号试图获得 HBM2E 优于三星的优势。)

内存通道的数量也从 HBM2 的 8 个通道增加到 HBM3 的 16 个通道的数量翻了一番,并且在架构中甚至支持 32 个“伪通道”,据此我们假设 DRAM 组之间可能存在某种交错,这通常是常见的在高端服务器主存储器中完成。HBM2 和 HBM2E 变体可以堆叠 4、8 或 12 个芯片高的 DRAM,而 HBM3 允许扩展到 16 个芯片高的 DRAM 堆叠。HBM3 的 DRAM 容量预计在 8 Gb 到 32 Gb 之间,使用 8 Gb 芯片的四层堆栈产生 4 GB 容量,使用 32 Gb 芯片的 16 层堆栈产生每个堆栈 64 GB。据 JEDEC 称,使用 HBM3 内存的第一代设备预计将基于 16 Gb 芯片。内存接口仍为 1,024 位宽,单个 HBM3 堆栈可驱动 819 GB/秒的带宽。

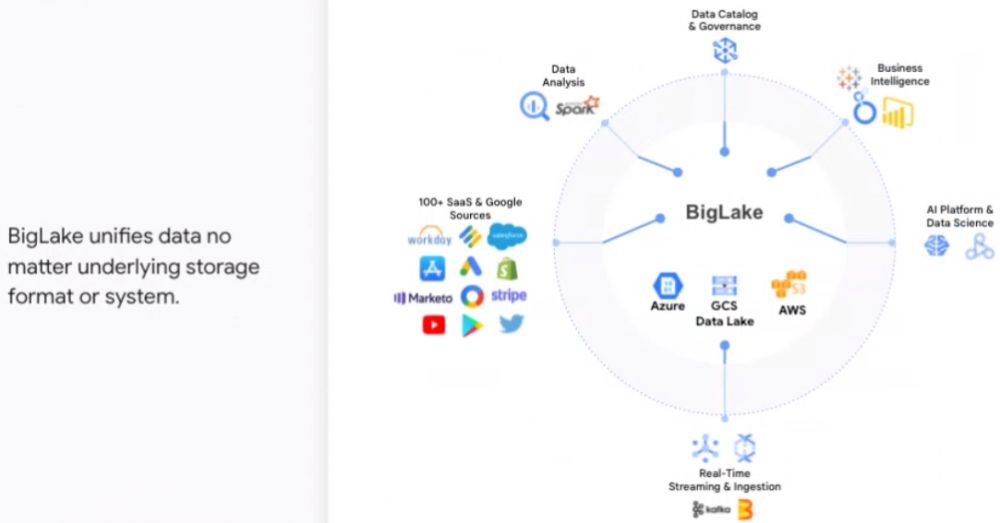

对 Gerrit Kazmaier 来说,托管数据库和数据湖之间的区别从来没有多大意义,而如今,随着数据堆积如山,被构造力推高,这种区别就更没有意义了。

“这种区别从来没有用过,”谷歌云数据库、数据分析和 Looker 总经理 Kazmaier 本周在与记者和分析师的虚拟会议上表示。“这是技术上的必要性,因为数据量一直在增长,而且在传统数据存储技术中管理它们变得过于复杂且成本过高。”

随着数据量的增加,组织转向数据仓库。随着数据量的进一步扩大——以及更高比例的非结构化数据——他们开始引入数据湖来完善他们的数据仓库。

“这产生了以相对较低的成本在不同的仓库中大规模存储大量数据的强烈需求,”Kazmaier 说。“这是数据湖运动的入口。但它付出了巨大的代价。对于所有这些试图在数据之上进行创新但最终发现它只是一个数据沼泽的组织来说,这付出了一致性、安全性和可管理性的巨大代价。”

它还在企业必须管理的 IT 环境中创建了单独的数据孤岛,这是其他供应商(从Hewlett Packard Enterprise和 Dell Technologies 到Pure Storage和Hitachi Vantara)正在努力解决的问题。今年早些时候,我们写了一家名为 Onehouse 的初创公司,该公司从隐身中脱颖而出,计划利用开源 Hudi 将数据库和数据仓库功能引入数据湖,创建可以容纳和管理结构化、半结构化和非结构化的 Lakehouse数据。

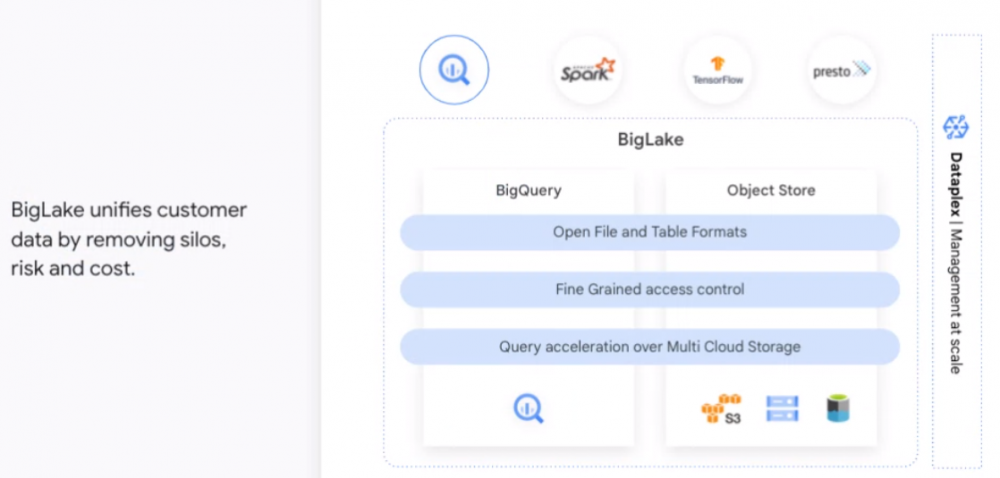

谷歌云正在寻求做类似的事情。在本周的数据云峰会上,该公司推出了 BigLake,它统一了数据仓库和数据湖,使组织能够通过单个数据副本存储、管理和分析其数据,而无需复制或移动数据或担心底层存储格式或系统。

BigLake 将 Google Cloud 的 BigQuery 数据仓库功能扩展到 Google Cloud Storage 上的数据湖,使用 API 接口对 Google Cloud 和开放格式(如 Parquet)和开源处理引擎(如 Apache Spark)进行更大的访问控制。它消除了 Kazmaier 所说的“托管仓库和数据湖之间的人为分离”。

BigLake 提供预览版,是 Google Cloud 在此次活动中推出的众多新产品和增强功能之一,这些产品和增强功能利用了该组织多年来通过 BigQuery、Vertex AI等数据工具所做的工作——一个集合使企业能够构建和管理机器学习工作负载的服务——Spanner 分布式 SQL 数据库管理和存储服务以及 Looker 商业智能平台。

所有这些以及数据库迁移计划等新产品及其合作伙伴计划中的更新旨在使企业能够更轻松地从他们创建的海量数据中获得更大的商业价值。谷歌云是全球第三大云提供商,约占全球收入的 10%,落后于亚马逊网络服务(约 33%)和微软 Azure(约 22%)。

解决数据挑战——不仅是存储和管理数据,还包括移动、处理、分析和保护数据——可以帮助 Google Cloud 继续加速其多年努力,以在企业中获得更大的影响力。市场研究公司 Statista 预测, 2025 年将创建超过180 泽字节的数据。

Kazmaier 说:“数据几乎是这个星球上每个高管的首要议程。” “我们相信,要转型,你实际上不能应用过时的技术、过时的架构和过时的想法来解锁真正拥有的无限潜力数据。…今天的数据是多格式的,它是流式的,并且是静止的,它跨越数据中心,甚至跨越今天的云。数据架构需要将所有这些结合在一起。”

Google Cloud 能够使用 BigQuery 等服务构建它在数据存储领域已经完成的工作,从而构建 BigLake。

“我们在 BigQuery 上拥有数以万计的客户,我们在所有治理、安全性和所有核心功能方面投入了大量资金,”他说。“我们正在从 BigQuery 中汲取创新,现在将其扩展到所有不同格式的数据,以及湖泊环境中,无论是在带有 Google Cloud 存储的 Google Cloud 上,还是在 AWS 上还是在 Azure 上。我们采用创新并将其扩展到其他数据湖环境。”

与 BigLake 一起,Google Cloud 很快将使数据工程师能够实时跟踪其 Spanner 数据库中的变化。即将推出的 Spanner 更改流可跟踪整个数据库的插入、更新和删除。这些更改可以复制到 BigQuery 以推动分析并存储在 Google Cloud Storage 中以确保合规性。

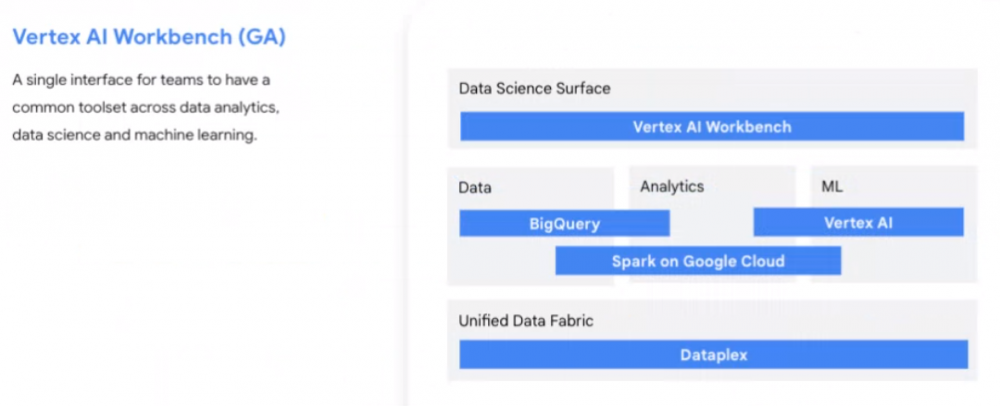

Vertex AI Workbench 现已上市,它为数据和机器学习系统创建了一个单一界面,为用户提供了一个用于数据分析、数据科学和机器学习以及直接访问 BigQuery 的通用工具集。Google Cloud 上云 AI 和分析服务副总裁 June Yang 表示,Workbench 还与 Serverless Spark 和 Dataproc 集成,使组织能够以比传统系统快五倍的速度构建、训练和部署机器学习模型。

此外,谷歌云还拥有 Vertex AI 模型注册表,这是一项预览服务,可让数据科学家更轻松地共享模型,并让开发人员更快速地将数据转化为预测。

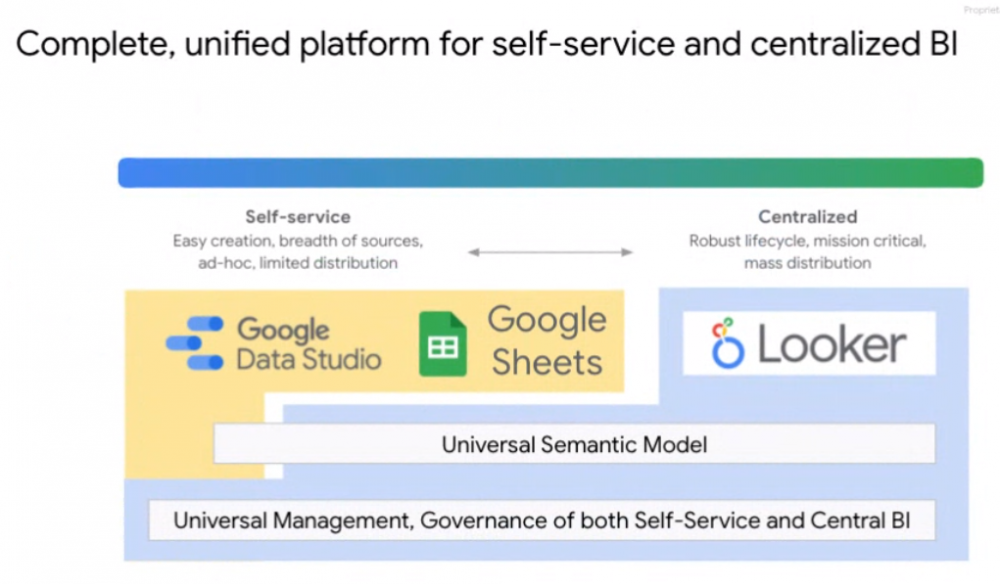

Connected Sheets 和 Data Studio for Looker 是 Google Cloud 将其商业智能服务组合更紧密地整合在一起的过程的一部分。

“我们将这两个世界结合在一起,”谷歌云产品管理总监 Sudhir Hasbe 说。“现在您可以使用 Data Studio 或 Tableau 等工具的自助服务功能,并使用 Looker 语义层的中央模型,您可以在一个地方定义您的指标,所有自助服务工具将无缝地工作和互动那。这将使组织和高级用户能够拥有自助服务工具,而且还可以集中指标并对整个组织的业务有一个共同的理解。”

如果 Google 最终成为超大规模和云构建者中 X86 架构的坚定支持者,这不是很有趣吗?

亚马逊网络服务过去几年一直在推动其 Graviton 产品线,自去年 3 月以来一直在生产 Graviton2,并且仍在预览其 Graviton3 芯片,该芯片于去年 11 月推出,但尚未全面生产——这意味着与提要、速度和价格——跨 AWS 区域和数据中心。

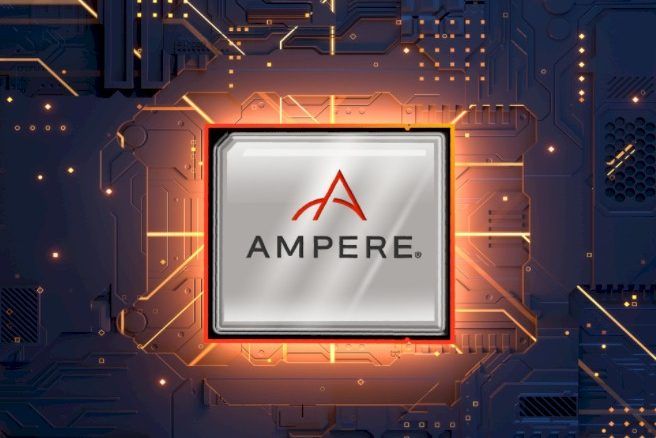

现在,微软正在通过 Azure 云上的新实例进入游戏,同样处于预览阶段,这些实例基于 Ampere Computing 制造的 80 核“Quicksilver”Altra Arm 服务器芯片,该芯片于两年前首次亮相2020 年 6 月,多达 80 个内核以 3 GHz 的最高速度运行。尽管本周关于使用这些 Ampere Computing Altra 处理器的新 Azure D 系列和 E 系列实例引起了很多争论,但奇怪的是为什么微软一年前——甚至更早——没有提供这些,以及为什么它是也没有部署 128 核的“Mystique”Altra Max 后续产品,这些产品原定于 2020 年第四季度提供样品,并于去年秋天开始供货。对微软来说,好消息是 Mystique 处理器与它现在部署的 Quicksilver 芯片的插槽兼容,因此它可以得到它们,它可以将 Altra Max 芯片融入其供应链、服务器和它的数据中心。

我们不期望未来的“Siryn”芯片,它可能不使用 Altra 品牌,并且基于我们称之为“A1”的本土核心,因为 Ampere Computing 不了解人们需要代号和最终产品名称,所以他们可以有效地谈论正在开发和交付的技术。(一两个同义词对读者和作者来说都是一件美好的事情。)在我们去年 5 月的安培计算路线图故事中,我们指出超大规模企业和云建设者购买的是路线图,而不是单点产品,甲骨文、腾讯、阿里巴巴等公司,现在微软正在为他们的公共云购买,因为他们相信 Ampere Computing 将获得下一代芯片,我们称之为“Polaris”,在没有名字的情况下,并有一个新的 A2 内核可以启动,正如预期的那样,在 2023 年推出.

仅仅因为 Ampere Computing 推出了它并不意味着它可以立即大量出货,或者超大规模和云构建者可以立即将 100,000 台机器放到他们的云中。量产、认证和建设都需要时间,而数据中心的这些阶段性变化将需要五到十年的时间才能成为实质性的。但是我们没有理由认为 Arm 服务器芯片无法达到 Arm Holdings 很久以前设定的 20% 到 25% 的目标——前提是一切运行良好。

微软毫不掩饰其希望看到 Arm 服务器芯片在 Azure 云上代表其大量容量的愿望——2017 年开放计算峰会的一次演讲称,目标是让 Arm 服务器成为服务器计算容量的 50% ——但微软没有承诺在 Azure 的基础设施云部分上提供 Arm 服务器(与用户购买 Microsoft 软件的访问权限而不是原始容量的平台和软件云部分相反),它同样没有承诺提供 Windows Server 堆栈在 Arm 上(尽管它在内部将 Windows-on-Arm 用于托管在 Azure 上的本土应用程序)。当微软在 2017 年同一场 OCP 峰会上公布其“奥林巴斯项目”设计时,Cavium ThunderX 服务器芯片和 Qualcomm Centriq 服务器芯片都在这些服务器上进行了预览。但高通取消了 Centriq 的插头,Marvell 收购了 Cavium,一段时间后取消了 ThunderX3 的插头。这让微软不得不选择设计自己的 Arm 服务器芯片或帮助 Ampere Computing 建立自己。(我们中的许多人认为微软最终会两者兼得。)

想知道在 Azure 中部署了多少 ThunderX2 铁(我们的猜测不是很多,否则 Marvell 会继续运行),以及现在 Azure 中有多少 Ampere Computing Altra 设备(我们的猜测可能更多)。微软正在基础设施云上提供 Arm 容量——在 VM 内运行 Linux 操作系统,但据我们所知,Windows Server 不支持,但这种情况也可能发生变化——这一事实意义重大。我们需要将此视为一桩桩桩桩事,以及微软的一份声明,即它不会让 AWS 完全靠其孤独来定义数据中心中 Arm 服务器的未来。

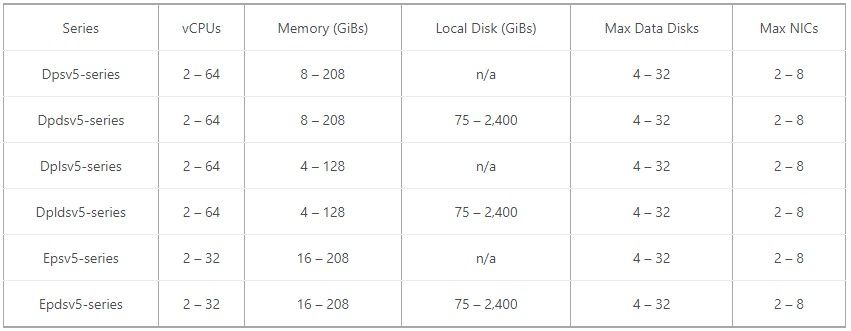

因为这些 Quicksilver Arm 实例处于技术预览阶段,所以我们对它们的了解比我们希望的要少得多,但是一旦它们退出预览版以及 AWS Graviton3 实例退出预览版,您就可以赌比尔盖茨的最后两美元和 Jeff Bezos,我们将进行价格/性能分析,比较这两种类型的 Arm 服务器实例以及 X86 熨斗这些大型云(世界上最大的两个云)的销售情况。事实上,我们构建了电子表格来进行比较,假设现在可以使用提要、速度和价格。值得称赞的是,微软已经公布了它推出的六种 Arm 服务器实例类型和一些基本的显着特征:

首先,每个芯片有 8 个 DDR4 内存控制器,Altra CPU 可以拥有比微软配置的更多的内存。Altra CPU 还支持 NUMA 集群,以创建更大的内存地址空间和计算引擎。目前尚不清楚这些 Azure 实例是基于单插槽设计还是双插槽设计。

我们想知道的第一件事,但微软没有回答,为什么当 Altra 芯片达到 80 核时,这些实例达到 32 核和 64 核?可能是它们是单插槽服务器,并且它们位于没有 DPU 来卸载网络和存储虚拟化的系统中,因此一些内核正在运行管理程序堆栈时被烧毁。可能是 Microsoft 服务器中有一个 DPU,而 32 核和 64 核部件是 Ampere Computing 在数量和价格方面的最佳选择。不管它是什么,没有一直运行它是有原因的,它是这两种情况之一。(或者,如果在 Arm 上运行的 Hyper-V 虚拟机管理程序确实效率低下,则可能两者兼而有之。)

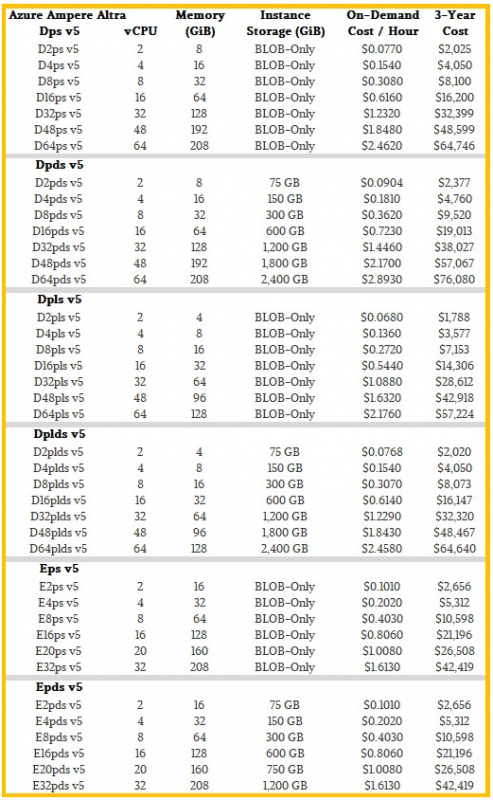

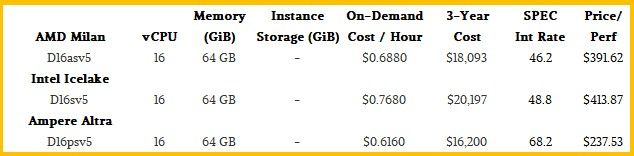

为了帮助了解不同 Azure Arm 服务器实例 SKU 的方式,我们汇总了这张表,其中包括按需实例的每小时成本。(现货定价也可用,但我们发现这作为跨云的通用指标不太有趣。)只是为了好玩,并让您了解运行这些实例的成本,只要物理服务器倾向于保留在超大规模和云数据中心,我们计算了三年内实例的成本。我们最终将以此作为跨云和云内价格/性能比较的基础。(如今,对于云中的服务器寿命而言,四年可能更准确。)

Azure 上的价格与虚拟 CPU 或 vCPU 的数量成线性关系,至少在此产品线中是这样。底层芯片的成本可能不会——每个实例在任何给定工作负载上的绝对性能也可能不会线性扩展。因此,不要假设价格/性能在各个实例中是恒定的。事实并非如此,正如我们去年这个时候展示的那样,AWS 与去年的 Graviton2 和 X86 实例当然也没有进行比较。

据微软称,Azure 上的 Dpsv5 系列实例旨在运行 Web 服务器、应用程序服务器、Java 和 .NET 应用程序、开源数据库以及游戏和媒体服务器。Dpsv5 实例的每个核心有 4 GB,没有本地磁盘,而 Dpdsv5 实例的每个核心有 4 GB 和随核心扩展的本地存储。Dplsv5 实例每个核心有 2 GB,Dpldsv5 实例相同,但具有本地存储。所有这四种实例类型都从 2 核扩展到 64 核。Epsv5 实例每个核心有 8 GB,但只能扩展到 32 个核心,并且 Epdsv5 实例添加了本地存储。(如果你能保持这些名字直截了当,对你有好处。)

没有本地存储的实例成本更低,并且 Microsoft 在 Azure 上提供的所有不同外部闪存存储选项都可用于这些 Arm 实例。这些实例有 2 到 8 个网络接口。微软表示,它提供“高达 40 Gb/秒”的网络连接,而且必须以某种方式为每个虚拟 NIC 提供。虚拟 NIC 的数量可能与每个虚拟 NIC 的带宽成反比,我们猜测每个物理服务器的管道只有 100 Gb/秒。但如果有两个以太网端口,它可能是 200 Gb/秒。我们会看到的。

这里有一件很重要的事情,我们已经与安培计算多次讨论过这个问题,并且从 AWS 那里听到了关于 Graviton 系列芯片的同样的话:一组具有静态时钟速度的真实内核优于一组虚拟内核在确定性性能方面具有可变的时钟速度。

使用 Ampere Computing Altra 芯片,没有同时多线程,或简称为 SMT,因此 vCPU 是实际的 CPU 内核。当谈到 Altra 时钟速度时,它们被锁定在一个速度上,并且没有这种可变的时钟速度取决于在任何给定时间使用的内核数量。云的前提是服务器以无数种方式与一百万客户进行分割,并且每个核心都保持忙碌,因此长时间超频一个或一组核心的机会不大,因为新的工作负载会现在随时来。Ampere Computing 的设计点——这是在听取了超大规模和云建设者的意见之后——是让 CPU 更具确定性。这意味着保持时钟速度恒定,而不是在内核上使用可能导致争用的虚拟线程。

请注意,并非总是如此,这也很重要。对于 HPC 工作负载,通常会关闭 SMT,因为管理虚拟线程的开销实际上会降低整体性能。对于喜欢大量线程的工作负载(例如,事务处理监视器和关系数据库),在内核缓存之间没有太多争用的情况下,可能会发疯。根据我们多年来看到的轶事证据,对于 HPC 风格的工作负载、英特尔的超线程或 HT,SMT 的实施可能会导致性能下降 10% 到 20%。另一方面,在 Power E1080 服务器中采用 IBM 的“Cumulus”Power10 处理器。一个全口径,根据 IBM 的 rPerf 基准测试(TPC-C 在线事务处理测试的 I/O 未绑定变体),240 核系统的相对性能为 2,250.8,每个核激活一个线程。随着虚拟线程的开启——每核 2 个,然后是 4 核,然后每核 8 个——性能扩展了 2 倍、2.8 倍和 3.6 倍。(那个 SMT4 跳转不如 SMT8 跳转。)

关键是,SMT 的影响是复杂的,每个使用 X86 Iron 的云都会在很多实例上打开它——我们不确定它是否通用——以提高其 vCPU 的粒度。它为他们提供了更小的切片和更多的 SKU,并且他们可以使使用中间 bin X86 CPU 的服务器看起来比实际更大。如果他们在 SMT 运行时告诉客户,那就太好了,如果他们不想要它,如果它给他们一个裸机选项,那就更好了。(许多人只是出于上述原因。)

现在,让我们谈谈性能。在宣布基于 Arm 的 Azure 实例的博客文章中,Azure 计算平台产品负责人 Paul Nash 表示:“新的 VM 系列包括通用 Dpsv5 和内存优化的 Epsv5 VM,可提供高达 50%比基于 X86 的 VM 具有更好的性价比。”

这种说法相当模糊,术语是“性价比”,因为它是一个部门,而不是一个产品。所以我们修正了上面的微软报价是准确的。

无论如何,微软的声明并没有告诉我们太多关于性能或价格/性能的具体信息。

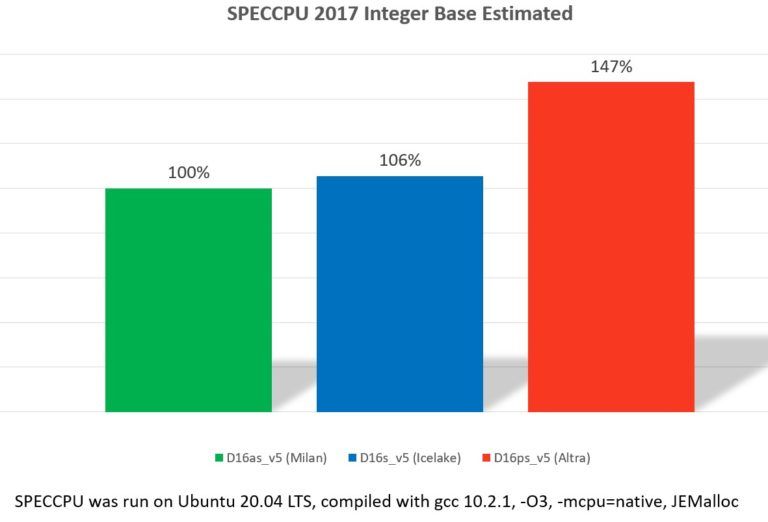

Ampere Computing 的首席产品官 Jeff Wittich 的这一声明使球向前推进了一点:“Ampere Altra VM 的性能分别比同代同等大小的 Intel 和 AMD 实例高出 39% 和 47%。*除了是作为高性能选择,Ampere Altra 处理器非常节能,直接减少了用户的总体碳足迹。”

上面的星号导致的脚注是这样说的:“基于 est. SPEC CPU 2017 Integer Base for D16ps v5, D16s v5, D16as v5 Azure VMs running on Ubuntu 20.04 LTS andcompiled with gcc 10.2.1, -O3, -mcpu=本地人,JEMalloc”

更接近了,但仍然不令人满意。SPECrate 是 CPU 通常用来衡量的吞吐量整数测试。(有一个基本结果,这意味着所有 SPEC 模块都使用相同的编译器标志进行编译,还有一个峰值结果,即使用任何编译器选项使其尖叫。)测试人员运行 SPEC 测试的多个副本并查看有多少事务吞吐量他们可以通过芯片。通过 SPECspeed2017 测试,套件中每个基准测试的一个副本以一系列方式运行,测试人员可以根据 OpenMP 选择使用多少线程,结果是时间的度量——完整的单运行测试。

我们联系了 Wittich,表达了对这种变幻莫测的失望,他向我们提供了在Ampere Computing 发布的关于 Azure 实例的简短博客中的比较参考之一中使用的实际数据:

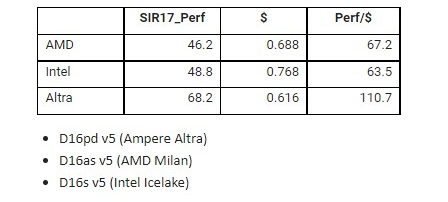

下表汇总了这些实例的原始 SPECrate2017 整数性能,这些实例基于 AMD、Intel 和 Ampere Computing 的最新 CPU,以及这些实例的每小时成本。由于两组数字的相对大小,Wittich 将性能除以成本,这告诉您在这三组中花费多少 SPEC Integer 吞吐量。

上表有一个错字,只是为了说明这些 Microsoft 实例名称的难易程度。测试的是 Altra D16psv5 实例,而不是 Altra D16pdv5。(后者有 600 GB 的闪存,而且成本更高。)

我们喜欢考虑每单位性能的成本,而不是每单位资金的性能,因此我们翻转数据并计算了 Ampere Computing 使用 SPEC 的整数率测试的三个不同实例的三年成本(无折扣)测试:

我们认为,如果您打算长时间使用云上的实例,这可以让您更好地了解它的成本。您得到的百分比与 Wittich 计算的相同。现在,如果您可以关闭 AMD 和 Intel 芯片上的 SMT 会发生什么?好吧,如果您正在考虑虚拟 CPU 数量,那么以一种思考方式,您将不得不购买两倍大的 AMD 和 Intel 实例。他们将有 16 个核心,这些核心会更强大,并且会做更多的工作。但这不是衡量标准,真的。

我们认为更合理的做法是退回到 AMD 和 Intel 芯片上的 8 个真实内核,并将性能提升 10% 到 20% 之间,看看会发生什么物有所值。如果这样做,那么 AMD “Milan” Epyc 7003 实例的 SPECrate Integer 性能将介于 50.8 和 55.4 之间,而 Intel “Ice Lake” Xeon SP 实例的 SPECrate Integer 性能将介于 53.7 和 58.6 之间。Altra 实例的价格仍然较低——比 Milan 低 10.5%,比 Ice Lake 低 19.8%——而且性能仍然更高——比 Milan 高 23% 到 34.2%,Ice 高 16.5% 到 27%湖。因此,Altra 芯片的性价比优势仍然很显着——一般来说,每单位性能的成本要低三分之一左右。

正如Google 七年前告诉我们的那样,它愿意改变 CPU 架构以获得可持续的 20% 的性价比优势。

最后一件事。Microsoft 在 Arm 实例上支持 Canonical Ubuntu Linux、CentOS 和 Windows 11 专业版和企业版,接下来将支持 Red Hat Enterprise Linux、SUSE Linux Enterprise Server、Debian、AlmaLinux 和 Flatcar。没有提到 Windows Server。

我们期待看到 AWS Graviton 和 Azure Altra 实例的性能数据,并看到这一切如何发挥作用。这是十多年前应该发生的事情。真正的竞争,不止一个方面。

马萨诸塞州尼德汉姆,2022 年 4 月 6 日——许多组织正在积极开展边缘之旅,因为他们寻求以新的方式与客户建立联系、提高运营效率并采用数字技术来支持创新。国际数据公司 ( IDC ) 的 EdgeView 2022 调查发现,四分之三的组织计划在未来两年内增加其边缘支出,平均增幅为 37%。

多种因素共同推动了边缘支出的增加。扩展工作负载和利用人工智能 (AI) 和机器学习 (ML) 的新用例的性能要求需要更大的边缘计算能力。此外,存储在边缘位置的数据量正在迅速扩大,组织计划将这些数据保留更长时间。因此,部署在边缘的物理服务器数量正在增加。大部分投资优先考虑边缘位置现有基础设施的现代化,而不是建设新的基础设施。

调查还发现,部署边缘的企业高度专注于建立可扩展的业务,其投资可以迅速为盈利做出贡献。边缘部署的首要目标是增加收入、改进产品和服务以及降低成本。但边缘部署也提供了填补利基市场或破坏现有市场的重要机会。

IDC 负责云和边缘基础设施服务的研究副总裁 Dave McCarthy 表示:“企业正在发出信号,他们希望从云运营模式中获得好处,并可以在任何地方自由部署。” “这为技术供应商创造了巨大的机会,可以在这些分布式环境中降低复杂性并保持一致性。”

Edge Strategies 研究总监 Jennifer Cooke 说:“边缘基础设施部署正在将 IT 重新转变为在组织内更具战略性和影响力的角色。“IT 组织正在推动和支持更广泛组织内的关键数字优先工作。”

EdgeView 2022 调查的其他主要发现包括:

组织将边缘解决方案与传统基础设施集成的能力列为关键选择标准,并认为它与边缘决策中的价格一样重要。但是,边缘管理策略并未与云和核心紧密集成,这表明组织在寻求将核心、云和边缘资源作为一组有凝聚力的灵活资源来利用时,可能需要修改其管理策略。

组织将继续在边缘部署和支持许多不同的计算、存储和网络架构。能够在多个环境中部署也是一个关键的选择标准,强调了组织将计算资源扩展到许多不同类型的环境的持续计划,包括云和核心数据中心以及现场。

出于必要并且由于需要利用云资源,边缘将继续成为云、托管、现场位置和公司拥有的数据中心的广泛组合。在接下来的两年中,预计三分之二的组织将更多地转向公共云资源。但总的来说,所有边缘类型都会增加。

关于设备所有权,大多数人表示他们的组织更愿意保留基础设施的所有权。这将推动对灵活消费模式的更大需求,这些模式具有云的运营成本优势以及更大的基础设施所有权和控制权。

此项研究可通过 IDC 的IDC EdgeView研究服务获得,该服务是IDC BuyerView实践的一部分。IDC 的 EdgeView 2022 调查使技术组织、硬件供应商、软件开发商、服务供应商和投资者能够更好地了解其客户的购买意图,并帮助制定战略和解决方案,解决当前和新兴的边缘技术和工作用例。这包括概述将基础架构和应用程序部署在更靠近数据生成和使用的地方的主要动机,并探索延迟、成本、弹性、安全性和合规性等方面。

关于 IDC

国际数据公司 (IDC) 是为信息技术、电信和消费技术市场提供市场情报、咨询服务和活动的全球首屈一指的供应商。IDC 在全球拥有 1,200 多名分析师,在 110 多个国家/地区提供有关技术、IT 基准测试和采购以及行业机会和趋势的全球、区域和本地专业知识。IDC 的分析和洞察力可帮助 IT 专业人士、业务主管和投资界做出基于事实的技术决策并实现其关键业务目标。IDC 成立于 1964 年,是全球领先的科技媒体、数据和营销服务公司International Data Group ( IDG )的全资子公司。

伦敦,2022 年 4 月 6 日——考虑到零售商和 CPG 公司处理来自不同接口和业务功能的大量非结构化和碎片化数据的快速变化的环境,数据准确性至关重要。对于旨在实现大规模实时上下文客户体验的公司而言,集成数据孤岛和利用 AI/ML 分析仍然是基础。

在消费行业,打破数据孤岛并遵守安全标准和法规是实施客户体验流程时面临的最大挑战之一。IDC 预测,“到 2024 年,用于推动个性化体验和改进全渠道营销、营销和服务智能的客户数据中,有 25% 将来自共享客户数据中心”(参见 IDC FutureScape:2022 年全球零售预测— IDC #US47249621,2021 年 10 月)。

IDC Retail Insights 旨在帮助零售商和 CPG 公司选择全球客户数据平台软件和专业提供商。IDC 新的全球零售和 CPG 客户数据平台软件供应商 2022 供应商评估 MarketScape评估主要企业软件供应商和专业 CDP 供应商在满足全球零售和 CPG 公司和品牌跨行业(食品和非食品)需求方面的能力和战略零售)。供应商根据他们在设计、开发、安装、配置和维护为零售商和 CPG 公司服务的完整客户数据平台的演进方面取得的成功进行评估。

该研究评估了 13 家供应商:Adobe、Algonomy、Amperity、BlueConic、Microsoft、mParticle、Optimove、Redpoint Global、Salesforce、SAP、SAS、Tealium 和 Treasure Data。供应商会根据一系列能力进行评估:

客户身份和隐私管理

零售和 CPG 特定服务和用例

CDP核心能力和功能

解决零售和/或 CPG 特定需求的外部合作

支持和培训服务

软件部署和支持

关于 IDC MarketScape

IDC MarketScape标准选择、权重和供应商分数代表了经过深入研究的 IDC 对市场和特定供应商的判断。IDC 分析师通过结构化的讨论、调查和与市场领导者、参与者和最终用户的访谈来定制衡量供应商的标准特征范围。市场权重基于每个市场的用户访谈、买家调查和 IDC 专家的意见。IDC 分析师基于对供应商的详细调查和访谈、公开信息和最终用户体验,对各个供应商的评分以及最终供应商在 IDC MarketScape 中的排名进行评估,以努力对每个供应商的特征、行为、和能力。

富士通已确认将通过新兴的云服务开放对支持全球顶级超级计算机“Fugaku”的相同系统架构的访问。

新的富士通计算即服务(CaaS)产品组合还将为希望探索人工智能和机器学习的量子模拟资源和服务的用户提供挂钩。

首先是富士通云服务 HPC,该公司从今天开始接受预订,预计 10 月份上市。

富士通表示,它将首先开始服务日本市场,随后将在全球范围内推广到包括欧洲、亚太地区和美洲在内的国际地区。

随后将提供访问富士通 Digital Annealer 技术的服务,该技术使用量子退火过程来寻找复杂问题的最佳解决方案,以及人工智能和机器学习服务。

富士通云服务 HPC 包括富士通 PRIMEHPC FX1000的计算能力,该计算能力基于 Fugaku 超级计算机中使用的相同 A64FX 64 位 Arm 芯片,根据TOP500 列表,该超级计算机仍然保持着世界上最快的桂冠。

PRIMEHPC FX1000 中的每个节点都围绕单个 48 核 A64FX 芯片构建,32GB HBM2 内存直接堆叠在芯片顶部,声称内存带宽为 1,024GB/s。PRIMEHPC FX1000 每个机架最多支持 384 个节点,由富士通自己的 Tofu D 高速结构互连。

据富士通称,HPC 服务将包括支持以及一套软件和库,以帮助客户部署 HPC 应用程序。它还将提供性能调整和应用程序分析服务,以支持专注于研究和分析的客户。

富士通表示,计算节点、登录节点、作业调度程序、存储和 HPC 应用软件都将提前配置,这意味着用户不必构建自己的 HPC 环境,只需要准备数据进行分析。用户只需为他们需要的资源付费。

富士通表示,订阅者使用富士通云 HPC 服务的方式是通过每月的“HPC 预算”,计算资源将按现收现付的方式消耗。

富士通告诉我们,最初将针对使用 HPC 节点所需的 HPC 预算制定三种定价计划,具体取决于周围使用的存储容量等条件。这些是每月 50,000 日元(约 400 美元)、每月 500,000 日元(约 4,000 美元)和每月 100 万日元(约 8,000 美元)。这些是日本初始服务的价格。

富士通似乎热衷于支持没有先前 HPC 知识或经验的客户,以通过专业的运营和技术支持帮助他们从云服务中受益,并根据个人客户的业务计划制定 HPC 使用计划。

富士通还表示,它的目标是在富士通云服务 HPC 与其 Fugaku 超级计算机之间实现高度兼容性,以便将 Fugaku 上产生的研究成果轻松地转移到 CaaS 服务中,以加速实际应用。相反,富士通还设想用户计划大规模分析和研究项目,以便在必要时能够将他们的应用程序迁移到 Fugaku。

据其计算科学中心主任松冈聪(Satoshi Matsuoka)称,这是日本RIKEN 研究所的科学家正在与富士通合作实现的一项能力。

“我们正在与富士通合作,使其 CaaS 与 Fugaku 高度兼容,以支持这些要求,我们希望 CaaS 成为快速将 Fugaku 的研发与工业用途和社会实际实施联系起来的重要服务,”他在一份声明中说。

“展望未来,我们将与富士通合作,将 Fugaku 与这项新服务进一步协同,以在云中无缝提供其功能。”

在这方面,富士通云服务 HPC 不同于其他一些 HPC 即服务产品,例如联想的TruScale和 HPE 的GreenLake for High Performance Computing,两者都在客户自己的数据中心或托管站点中提供物理基础设施,但作为托管服务。

对于企业而言,另一种选择是与云服务提供商合作,正如我们的姊妹网站The Next Platform所讨论的那样,AWS、Azure 和 Google Cloud 都提供 HPC 功能。然而,这些通常要求客户通过单独的服务自行组合和管理解决方案,而富士通则提供支持服务作为交易的一部分。

Hyperion Research 的 HPC Market Dynamics 高级顾问 Steve Conway 表示,富士通的举动并非史无前例,而且已经有各种各样的 HPC 服务。

“富士通基本上只是加入了人群,”他说。

然而,更大的图景是,日本政府正在推动富士通将其超级计算机的可用性扩展到国内市场之外。“日本试图跟上超级计算领导者的步伐,他们做得很好,但它主要服务于国内市场。现在政府已经下令向非日本研究人员开放,”康威说.

富士通的 K5 混合云服务作为公共、私有虚拟或私有托管服务进行销售和部署,直到2018 年在除日本以外的世界所有地区被彻底淘汰。从那时起,它对员工进行了培训,使其在 AWS 和Azure公有云方面更加熟练